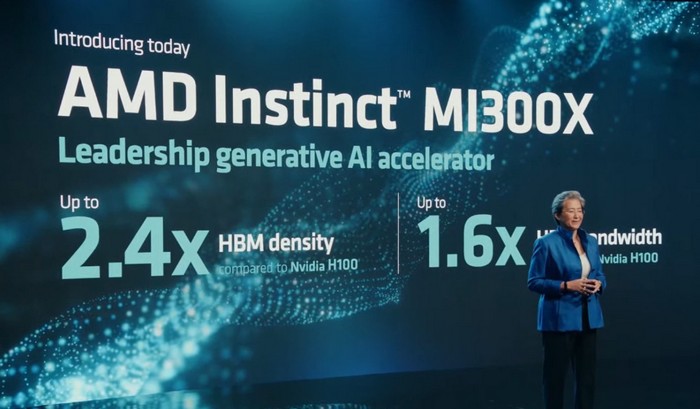

AMD 还发布了 Instinct MI300系列加速卡,其中MI300X拥有惊人的192GB HBM3 超大显存,大语言模型专用,挑战NVIDIA。

AMD表示,这是世界上最先进的 AI 加速卡,基于新一代 AMD CDNA3 架构,核心拥有多达1530亿颗晶体管,支持高达 192GB HBM3 类型显存,是英伟达H100的2.4倍,高带宽内存带宽最高可达H100的1.6倍,显然MI300X能运行比H100更大的AI模型。为生成语音大模型训练和推理提供高效算力。

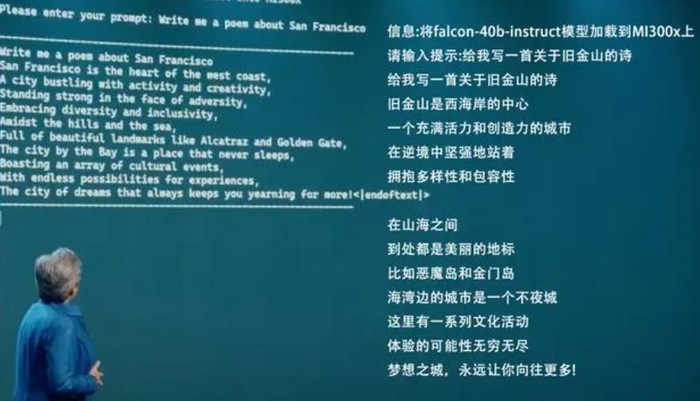

AMD CEO苏大妈还现场实战,演示了其计算速度,利用Hugging Face 的 falcon-40b-instruct模型,写了首关于旧金山(这次AMD发布会地址)的小诗。另外,现场还展示了MI300X运行包括GPT-3、PaLM2等大模型的优势:

MI300系列有标准版MI300A和MI300X强化版。

MI300A针对AI和高性能计算(HPC),有13个小芯片,包含9个5nm制程GPU+CPU,以及4个6nm制程的小芯片(base dies),包含1460亿个晶体管,其中有24个Zen 4 CPU核心,1个CDNA 3图形引擎,128GB的HBM3内存。

MI300X是针对大语言模型(LLM)专用,包含12个小芯片,1530亿个晶体管,192GB的HBM3内存,内存带宽达到5.2TB/s,Infinity Fabric带宽达到896GB/s。

最后,AMD还发布了基于MI300X的AMD Instinct计算平台,由8个MI300X组成,1.5TB HBM3显存,将于今年Q3季度上市。

声明:本站所有文章,如无特殊说明或标注,均为本站原创发布。任何个人或组织,在未征得本站同意时,禁止复制、盗用、采集、发布本站内容到任何网站、书籍等各类媒体平台。如若本站内容侵犯了原著者的合法权益,可联系我们进行处理。

评论(0)